Les logiciels de sécurité informatique s’appuient de plus en plus sur l’apprentissage automatique pour améliorer la détection de logiciels malveillants. Le hic : avec du savoir-faire, les pirates pourraient berner systématiquement ces systèmes d’intelligence artificielle.

L’apprentissage automatique profond, ou « Deep Learning », bouleverse de nombreux secteurs économiques. Il n’est pas donc étonnant que cette technologie apparaisse également chez les éditeurs antivirus. La détection de malware est avant tout un problème de classification auquel le Deep Learning peut apporter de nouvelles réponses.

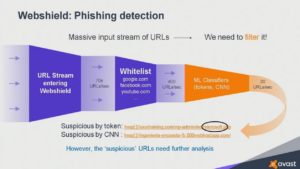

A l’occasion de la conférence CyberSec & AI, qui s’est déroulée à Prague au mois d’octobre dernier, l’éditeur Avast a détaillé quelques techniques d’ores et déjà en production. Ainsi, son module de protection Web Shield s’appuie sur des réseaux de neurones convolutifs pour trier les 70 000 URLs sur lesquels se rendent ses 400 millions de clients chaque seconde et, le cas échéant, détecter celles qui sont malveillantes.

Un premier réseau de neurones va essayer de détecter des anomalies dans l’adresse elle-même, tant au niveau de sa structure que de l’agencement des lettres. Un second réseau de neurones va ensuite prendre une copie d’écran du site et analyser certaines parties de l’image et la comparer à des sites légitimes existants. « Si la page ressemble à une page du site d’Apple, mais que l’adresse ne fait pas partie de son domaine, alors c’est une URL malveillante », explique Rajarshi Gupta, vice-président en charge de l’intelligence artificielle.

L’apprentissage automatique est également utilisé dans le module d’analyse comportementale (Behaviour Shield) pour mieux détecter les attaques réseaux chez les clients. Grâce à ses pots de miel (sorte de leurre), l’éditeur dispose d’une liste noire d’environ 2 millions d’adresses IP de serveurs de commande et contrôle. « Mais c’est difficile d’intégrer une telle liste noire en local chez nos clients. Un réseau neuronal nous permet de ne retenir que les serveurs C & C (botnets) les plus virulents. Au final, nous obtenons une liste de 200 000 adresses couvrant 95 % des attaques », poursuit Rajarshi Gupta. D’autres réseaux neuronaux ont été entraînés pour détecter des modes opératoires – tels que les attaques par force brute – ou des trafics suspects. Ce qui est utile si l’adresse IP utilisée par les pirates est totalement inconnue.

Mais le domaine de la sécurité informatique a aussi ses difficultés. Ainsi, les éditeurs antivirus ne peuvent que difficilement s’appuyer sur des données étiquetées, qui sont pourtant un ingrédient fondamental pour entraîner un algorithme et créer un modèle. « On ne peut pas faire comme dans la reconnaissance d’image et avoir des gens qui disent “ceci est un malware” ou “ceci n’est pas un malware”. Il y a trop de données à analyser et trop peu de personnes qualifiées capables de le faire », explique Rajarshi Gupta. C’est pourquoi les éditeurs vont essayer de générer les étiquettes de manière indirecte, soit avec des méthodes statistiques, soit au travers d’autres procédés.

Ainsi, Avast stocke toutes les URL visitées par ses clients dans un gigantesque graphe. Quand des clients se retrouvent infectés, celui-ci lui permet de déterminer par recoupements l’URL qui est à l’origine de cette attaque, et donc de créer un label qui viendra alimenter le modèle de Web Shield.

L’IA, une technologie aux pieds d’argile

Malheureusement, les modèles de classification obtenu par apprentissage automatique ne sont pas à l’abri d’erreurs. Pire : les chercheurs en intelligence artificielle ont montré ces dernières années qu’il était possible d’identifier cette marge d’erreur et d’injecter des données dans un fichier pour systématiquement faire planter le classifieur. On appelle cela les « attaques contradictoires » (adversarial attacks). Par le passé, elles ont déjà permis d’induire en erreur les systèmes de reconnaissance d’image, y compris ceux de voitures autonomes comme les Tesla. Dans certains cas, il est même possible de créer une image qui fasse planter le système alors que le changement est imperceptible à l’œil nu.

Mais peut-on également envisager ce genre d’attaques dans le domaine des logiciels malveillants ? La réponse est oui. D’ailleurs, les pirates le font déjà de manière empirique. Quand ils modifient légèrement les textes de leurs e-mails de phishing ou le code de leurs malwares, ils cherchent à passer entre les mailles du filet de l’IA.

Modifier un malware est évidemment plus difficile que changer quelques pixels dans une image, car le code risque de ne plus fonctionner. « Les techniques d’évasion généralement utilisées sont le rembourrage avec des données aléatoire, l’ajout de fichiers bénins, la compression, le chiffrement ou encore l’injection de fonctions malveillantes dans un fichier légitime », explique Sadia Afroz, chercheuse à l’université de Berkeley. En janvier dernier, un groupe de chercheurs italiens a montré que MalConv, un réseau neuronal spécialisé dans la détection de malware sur Windows, pouvait être trompé de manière systématique en ajoutant seulement quelques dizaines d’octets dans l’entête des fichiers.

Pour copier un modèle, il suffit de l’interroger

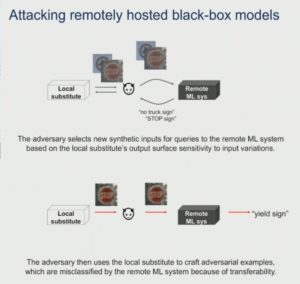

Autre bonne nouvelle pour les pirates : il n’est pas nécessaire de connaître par avance le fonctionnement d’une intelligence artificielle pour réussir à la duper. Il est possible, en effet, d’y arriver par une analyse de type boîte noire, en lui soumettant des données à classer. « En interrogeant le système d’IA, un attaquant peut identifier ses caractéristiques et recréer un modèle similaire à partir duquel il pourra générer les erreurs de classement », explique Nicolas Papernot, professeur à l’université de Toronto. Paradoxalement, l’effort nécessaire pour extraire un modèle est bien plus faible que celui requis pour sa création initiale. Dans les expériences réalisées par Nicolas Papernot sur les plates-formes d’intelligence artificielle d’Amazon, de Google et de MetaMind, quelques milliers de requêtes suffisaient alors que les modèles étaient entraînés sur plus de 60 000 images.

Se protéger contre ces attaques n’est pas aisé. Les chercheurs se cassent actuellement la tête pour rendre les modèles d’apprentissage automatique plus robustes, sans les faire perdre en précision. Faut-il, dès lors, bientôt craindre une guerre de l’IA dans la sécurité informatique ? Pas dans l’immédiat, car les pirates n’ont pas encore les compétences suffisantes pour s’attaquer de manière systématique aux systèmes d’intelligence artificielle.

Mais les compétences en IA vont bien finir par se démocratiser et les pirates trouveront peut-être des cibles suffisamment rentables pour mettre des data scientists à leur solde. Ce n’est qu’une question de temps. « A mesure que les niveaux de protection augmenteront, les pirates vont se tourner vers ce genre de techniques pour arriver à leurs fins », estime Battista Biggio, professeur à l’université de Cagliari.

Quand ce jour arrivera, les éditeurs antivirus vont avoir de sérieux problèmes et ils le savent. C’est pourquoi ils cherchent à avoir constamment une longueur d’avance en attirant un maximum de chercheurs spécialisés. « La sécurité informatique est le seul domaine où les systèmes d’intelligence artificielle sont confrontés à de vrais adversaires. C’est le seul domaine où ils doivent classer des éléments qui ont été créés pour ne pas l’être », a lancé Rajarshi Gupta à la fin de la conférence. Son but était clair : susciter des vocations parmi les experts présents dans la salle… et peut-être leur proposer un job.

Source : 01net