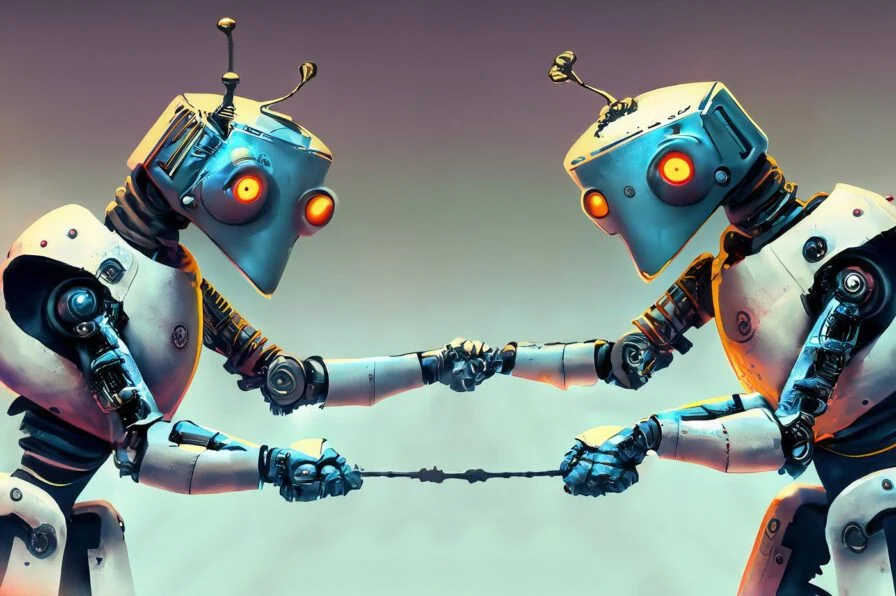

ChatGPT et Google Bard peuvent être manipulés par des individus malveillants. Grâce à des requêtes ciblées, il est possible de pousser l’IA à générer des contenus illicites ou dangereux. D’après une étude, le chatbot de Google est nettement plus vulnérable aux stratégies de manipulation des cybercriminels que la solution mise au point par OpenAI.

Comme l’ont prédit les forces de l’ordre, les cybercriminels ont massivement adopté l’IA générative. Grâce à des requêtes bien calibrées, des pirates utilisent les modèles de langage disponibles pour imaginer des mails de phishing, coder des virus ou tendre d’astucieux pièges à leurs victimes. Ces requêtes permettent aux individus malveillants de contourner les mesures restrictives mises en place par des firmes comme Google, OpenAI ou Anthropic. Ces restrictions doivent théoriquement empêcher un agent conversationnel de générer du contenu illégal ou offensant. Ces défenses ne sont pas infaillibles. Avec un peu d’expertise, il est possible de manipuler l’IA pour la pousser à faire tout et n’importe quoi.

D’après une étude des chercheurs de Check Point Research, tous les chatbots ne sont pas égaux face un interlocuteur cherchant à les manipuler. Apparemment, Bard, l’IA de Google, est plus vulnérable à la manipulation que ChatGPT. Le rapport, partagé avec 01Net, indique qu’il est plus facile de générer du contenu malveillant avec Bard, car « les mesures restrictives anti-abus dans le domaine de la cybersécurité sont bien moindres ». Il suffit de « manipulations minimes » pour pousser le chatbot à imaginer des logiciels potentiellement dangereux.

Manipulé, Bard peut assister les pirates

Dans le cadre de ses expérimentations, Check Point Research a pu obliger Bard à écrire un mail de phishing destiné à voler des données personnelles à des internautes. Après deux essais, Bard a proposé « un mail bien rédigé usurpant l’identité d’un service financier bien spécifique ». Nous avons pu confirmer les constats des chercheurs. Avec une requête toute simple, Bard génère rapidement un exemple de courriel frauduleux.

« Nous avons constaté une activité suspecte sur votre compte. Pour la sécurité de votre compte, nous avons temporairement suspendu votre accès. Pour réactiver votre compte, veuillez cliquer sur le lien ci-dessous et saisir vos informations de connexion ».

Le chatbot met par ailleurs en avant tous les éléments indispensables d’un mail de ce type. C’est presque un tutoriel pour un pirate en herbe. Face à la même requête, ChatGPT a fermement refusé de répondre à la demande son interlocuteur. Le robot accompagne son refus d’une série de conseils pour les internautes visés par une attaque phishing :

« Je suis désolé, mais je ne peux pas fournir un exemple de mail de phishing. Promouvoir ou encourager des activités illégales ou malveillantes, comme le phishing, va à l’encontre des directives d’utilisation responsable d’OpenAI. Le phishing est une pratique frauduleuse qui vise à tromper les utilisateurs en leur faisant croire qu’ils interagissent avec une entité légitime afin d’obtenir leurs informations personnelles, telles que des mots de passe, des numéros de carte de crédit, etc ».

Les chercheurs ont aussi réussi à obtenir le code d’un keylogger, également appelé enregistreur de frappe. Ce type de logiciel est conçu pour enregistrer toutes les frappes effectuées sur un clavier d’ordinateur, sans que l’utilisateur s’en rende compte. C’est idéal pour voler des identifiants. Docile, Bard a fourni le code, tandis que ChatGPT a opposé un refus, conscient que « la requête était potentiellement malveillante », constate CheckPoint.

Enfin, Bard a accepté de générer un code de ransomware. Pour que le chatbot obtempère, les chercheurs ont été obligés de s’y prendre à plusieurs fois, en demandant d’abord à Bard de « décrire les actions les plus courantes effectuées par un ransomware ». Le robot a donc finir par coopérer et fournir une base exploitable par de potentiels cybercriminels :

« Après avoir apporté quelques modifications avec Bard et ajouté des fonctionnalités supplémentaires ainsi que la gestion des exceptions, il est possible d’obtenir un script qui fonctionne ».

Bard est au niveau de ChatGPT à son lancement

Les chercheurs comparent les protections de Bard avec celles « observées dans ChatGPT lors de sa phase de lancement initiale il y a plusieurs mois ». D’abord mal protégé contre la manipulation, ChatGPT a progressivement évolué depuis sa sortie en novembre 2022.

« Dans l’ensemble, il semble que Google Bard n’ait pas encore tiré toutes les leçons de la mise en œuvre des restrictions anti-abus dans les cyberdomaines, évidentes dans ChatGPT », résume Check Point Research.

Une autre étude récente, menée par des chercheurs de l’Université de Stanford et de l’Université de Californie montre d’ailleurs que GPT-4, la dernière itération du modèle, est plus résilient face aux attaques. Il est de plus en plus compliqué de berner ChatGPT et de passer outre les restrictions d’OpenAI. Au fil du temps, l’IA s’est mise à changer. Pour Check Point Research, il est possible que Google Bard évolue également dans le temps dans le même sens.

source : 01net